入門知識

推薦書籍

1、舍恩伯格的《大數(shù)據(jù)時代》;

2、巴拉巴西的《爆發(fā)》;

3、涂子沛的《大數(shù)據(jù)》;

4、吳軍《智能時代》;

5、《大數(shù)據(jù)架構商業(yè)之路:從業(yè)務需求到技術方案》

工具技能

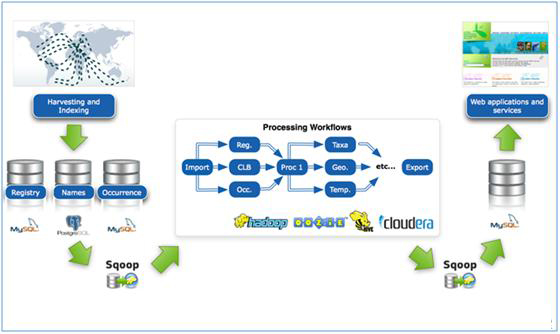

1、hadoop: 常用于離線的復雜的大數(shù)據(jù)處理

2、Spark:常用于離線的快速的大數(shù)據(jù)處理

3、Storm:常用于在線的實時的大數(shù)據(jù)處理

4、HDFS:Hadoop分布式文件系統(tǒng)。HDFS有著高容錯性的特點,并且設計用來部署在低廉的硬件上。而且它提供高吞吐量來訪問應用程序的數(shù)據(jù),適合那些有著超大數(shù)據(jù)集的應用程序。

5、Hbase:是一個分布式的、面向列的開源數(shù)據(jù)庫。該技術來源于 Fay Chang 所撰寫的Google論文“Bigtable:一個結構化數(shù)據(jù)的分布式存儲系統(tǒng)”。就像Bigtable利用了Google文件系統(tǒng)(File System)所提供的分布式數(shù)據(jù)存儲一樣,HBase在Hadoop之上提供了類似于Bigtable的能力。HBase是Apache的Hadoop項目的子項目。HBase不同于一般的關系數(shù)據(jù)庫,它是一個適合于非結構化數(shù)據(jù)存儲的數(shù)據(jù)庫。另一個不同的是HBase基于列的而不是基于行的模式。

6、Hive:hive是基于Hadoop的一個數(shù)據(jù)倉庫工具,可以將結構化的數(shù)據(jù)文件映射為一張數(shù)據(jù)庫表,并提供簡單的sql查詢功能,可以將sql語句轉換為MapReduce任務進行運行。 其優(yōu)點是學習成本低,可以通過類SQL語句快速實現(xiàn)簡單的MapReduce統(tǒng)計,不必開發(fā)專門的MapReduce應用,十分適合數(shù)據(jù)倉庫的統(tǒng)計分析。

7、Kafka:是一種高吞吐量的分布式發(fā)布訂閱消息系統(tǒng),它可以處理消費者規(guī)模的網(wǎng)站中的所有動作流數(shù)據(jù)。 這種動作(網(wǎng)頁瀏覽,搜索和其他用戶的行動)是在現(xiàn)代網(wǎng)絡上的許多社會功能的一個關鍵因素。 這些數(shù)據(jù)通常是由于吞吐量的要求而通過處理日志和日志聚合來解決。 對于像Hadoop的一樣的日志數(shù)據(jù)和離線分析系統(tǒng),但又要求實時處理的限制,這是一個可行的解決方案。Kafka的目的是通過Hadoop的并行加載機制來統(tǒng)一線上和離線的消息處理,也是為了通過集群來提供實時的消費。

8、redis:redis是一個key-value存儲系統(tǒng)。和Memcached類似,它支持存儲的value類型相對更多,包括string(字符串)、list(鏈表)、set(集合)、zset(sorted set –有序集合)和hash(哈希類型)。這些數(shù)據(jù)類型都支持push/pop、add/remove及取交集并集和差集及更豐富的操作,而且這些操作都是原子性的。

數(shù)據(jù)挖掘十大經(jīng)典算法

1:C4.5

C4.5就是一個決策樹算法,它是決策樹(決策樹也就是做決策的節(jié)點間像一棵樹一樣的組織方式,其實是一個倒樹)核心算法ID3的改進算法,所以基本上了解了一半決策樹構造方法就能構造它。決策樹構造方法其實就是每次選擇一個好的特征以及分裂點作為當前節(jié)點的分類條件。C4.5比ID3改進的地方時:

ID3選擇屬性用的是子樹的信息增益(這里可以用很多方法來定義信息,ID3使用的是熵(entropy)(熵是一種不純度度量準則)),也就是熵的變化值,而C4.5用的是信息增益率。也就是多了個率嘛。一般來說率就是用來取平衡用的,就像方差起的作用差不多,比如有兩個跑步的人,一個起點是100m/s的人、其1s后為110m/s;另一個人起速是1m/s、其1s后為11m/s。如果僅算加速度(單位時間速度增加量)那么兩個就是一樣的了;但如果使用速度增加率(速度增加比例)來衡量,2個人差距就很大了。在這里,其克服了用信息增益選擇屬性時偏向選擇取值多的屬性的不足。在樹構造過程中進行剪枝,我在構造決策樹的時候好討厭那些掛著幾個元素的節(jié)點。對于這種節(jié)點,干脆不考慮最好,不然很容易導致overfitting。對非離散數(shù)據(jù)都能處理,這個其實就是一個個式,看對于連續(xù)型的值在哪里分裂好。也就是把連續(xù)性的數(shù)據(jù)轉化為離散的值進行處理。能夠對不完整數(shù)據(jù)進行處理,這個重要也重要,其實也沒那么重要,缺失數(shù)據(jù)采用一些方法補上去就是了。

2:CART

CART也是一種決策樹算法!相對于上著有條件實現(xiàn)一個節(jié)點下面有多個子樹的多元分類,CART只是分類兩個子樹,這樣實現(xiàn)起來稍稍簡便些。所以說CART算法生成的決策樹是結構簡潔的二叉樹。

3:KNN(K Nearest Neighbours)

這個很簡單,就是看你周圍的K個人(樣本)中哪個類別的人占的多,哪個多,那我就是多的那個。實現(xiàn)起來就是對每個訓練樣本都計算與其相似度,是Top-K個訓練樣本出來,看這K個樣本中哪個類別的多些,誰多跟誰。

4:Naive Bayes

(樸素貝葉斯NB)

NB認為各個特征是獨立的,誰也不關誰的事。所以一個樣本(特征值的集合,比如“數(shù)據(jù)結構”出現(xiàn)2次,“文件”出現(xiàn)1次),可以通過對其所有出現(xiàn)特征在給定類別的概率相乘。比如“數(shù)據(jù)結構”出現(xiàn)在類1的概率為0.5,“文件”出現(xiàn)在類1的概率為0.3,則可認為其屬于類1的概率為0.5*0.5*0.3。

5:Support Vector Machine (支持向量機SVM)

SVM就是想找一個分類得最”好”的分類線/分類面(最近的一些兩類樣本到這個”線”的距離最遠)。這個沒具體實現(xiàn)過,上次聽課,那位老師自稱自己實現(xiàn)了SVM,敬佩其鉆研精神。常用的工具包是LibSVM、SVMLight、MySVM。

6:EM (期望最大化)

這個我認為就是假設數(shù)據(jù)時由幾個高斯分布組成的,所以最后就是要求幾個高斯分布的參數(shù)。通過先假設幾個值,然后通過反復迭代,以期望得到最好的擬合。

7:Apriori

這個是做關聯(lián)規(guī)則用的。不知道為什么,一提高關聯(lián)規(guī)則我就想到購物籃數(shù)據(jù)。這個沒實現(xiàn)過,不過也還要理解,它就是通過支持度和置信度兩個量來工作,不過對于Apriori,它通過頻繁項集的一些規(guī)律(頻繁項集的子集必定是頻繁項集等等啦)來減少計算復雜度。

8:PageRank

大名鼎鼎的PageRank大家應該都知道(Google靠此專利發(fā)家,其實也不能說發(fā)家啦!)。對于這個算法我的理解就是:如果我指向你(網(wǎng)頁間的連接)則表示我承認你,則在計算你的重要性的時候可以加上我的一部分重要性(到底多少,要看我自己有多少和我共承認多少個人)。通過反復這樣來,可以求的一個穩(wěn)定的衡量各個人(網(wǎng)頁)重要性的值。不過這里必須要做些限制(一個人的開始默認重要性都是1),不然那些值會越來越大越來越大。

9:K-Means

K-Means是一種最經(jīng)典也是使用最廣泛的聚類方法,時至今日扔然有很多基于其的改進模型提出。K-Means的思想很簡單,對于一個聚類任務(你需要指明聚成幾個類,當然按照自然想法來說不應該需要指明類數(shù),這個問題也是當前聚類任務的一個值得研究的課題),首先隨機選擇K個簇中心,然后反復計算下面的過程直到所有簇中心不改變(簇集合不改變)為止:步驟1:對于每個對象,計算其與每個簇中心的相似度,把其歸入與其最相似的那個簇中。

步驟2:更新簇中心,新的簇中心通過計算所有屬于該簇的對象的平均值得到。

k-means 算法的工作過程說明如下:首先從n個數(shù)據(jù)對象任意選擇k 個對象作為初始聚類中心;而對于所剩下其它對象,則根據(jù)它們與這些聚類中心的相似度(距離),分別將它們分配給與其最相似的(聚類中心所代表的)聚類;然后再計算每個所獲新聚類的聚類中心(該聚類中所有對象的均值);不斷重復這一過程直到標準測度函數(shù)開始收斂為止。一般都采用均方差作為標準測度函數(shù). k個聚類具有以下特點:各聚類本身盡可能的緊湊,而各聚類之間盡可能的分開。

10:AdaBoost

AdaBoost做分類的一般知道,它是一種boosting方法。這個不能說是一種算法,應該是一種方法,因為它可以建立在任何一種分類算法上,可以是決策樹,NB,SVM等。

Adaboost是一種迭代算法,其核心思想是針對同一個訓練集訓練不同的分類器(弱分類器),然后把這些弱分類器集合起來,構成一個更強的最終分類器(強分類器)。其算法本身是通過改變數(shù)據(jù)分布來實現(xiàn)的,它根據(jù)每次訓練集之中每個樣本的分類是否正確,以及上次的總體分類的準確率,來確定每個樣本的權值。將修改過權值的新數(shù)據(jù)集送給下層分類器進行訓練,最后將每次訓練得到的分類器最后融合起來,作為最后的決策分類器。使用adaboost分類器可以排除一些不必要的訓練數(shù)據(jù),并將關鍵放在關鍵的訓練數(shù)據(jù)上面。

應用數(shù)學基礎

線性代數(shù)

1、標量、向量、矩陣和張量

2、矩陣和向量相乘

3、單位矩陣和逆矩陣

4、線性相關和生成子空間

5、范數(shù)

6、特殊類型的矩陣和向量

7、特征分解

8、奇異值分解

9、Moore-Penrose 偽逆

10、跡運算

11、行列式

12、實例:主成分分析

概率與信息論

1、為什么要使用概率?

2、隨機變量

3、概率分布

4、邊緣概率

5、條件概率

6、條件概率的鏈式法則

7、獨立性和條件獨立性

8、期望、方差和協(xié)方差

9、常用概率分布

10、常用函數(shù)的有用性質

11、貝葉斯規(guī)則

12、連續(xù)型變量的技術細節(jié)

13、信息論

14、結構化概率模型

數(shù)值計算

1、上溢和下溢

2、病態(tài)條件

3、基于梯度的優(yōu)化方法

4、約束優(yōu)化

5、實例:線性最小二乘

這些大數(shù)據(jù)所需要學習到的知識,你都學會了嗎?